I denne Big data Hadoop tutorial , vil vi give dig en detaljeret beskrivelse af Hadoop HDFS-datablok. Først og fremmest vil vi dække, hvad der er datablok i Hadoop, hvad er deres betydning, hvorfor størrelsen af HDFS-datablokke er 128 MB.

Vi vil også diskutere eksemplet med datablokke i hadoop og forskellige fordele ved HDFS i Hadoop.

Introduktion til HDFS-datablok

Hadoop HDFS opdele store filer i små bidder kendt som blokke . Blok er den fysiske repræsentation af data. Den indeholder et minimum af data, der kan læses eller skrives. HDFS gemmer hver fil som blokke. HDFS-klienten har ikke nogen kontrol på blokken som blokplacering, Namenode bestemmer alle sådanne ting.

Som standard er HDFS-blokstørrelsen 128 MB som du kan ændre efter dit behov. Alle HDFS-blokke har samme størrelse undtagen den sidste blok, som enten kan have samme størrelse eller mindre.

Hadoop framework deler filer op i 128 MB blokke og gemmer derefter i Hadoop filsystemet. Apache Hadoop-applikationen er ansvarlig for at distribuere datablokken på tværs af flere noder.

Eksempel-

Antag, at filstørrelsen er 513 MB, og vi bruger standardkonfigurationen på blokstørrelsen 128 MB. Derefter vil Hadoop-rammen skabe 5 blokke, de første fire blokke 128 MB, men den sidste blok vil kun være på 1 MB.

Fra eksemplet er det derfor klart, at det ikke er nødvendigt, at hver fil, der lagres i HDFS, skal være et nøjagtigt multiplum af den konfigurerede blokstørrelse 128mb, 256mb osv. Derfor bruger den sidste blok for fil kun så meget plads, som det er nødvendigt.

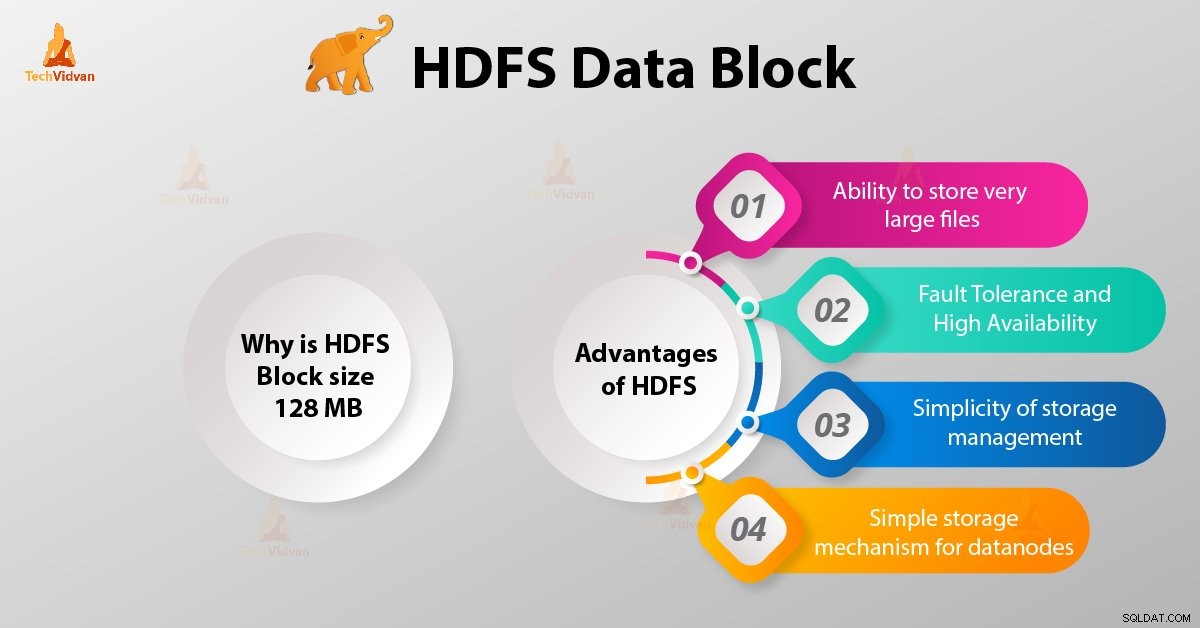

Hvorfor er HDFS-blokstørrelsen 128 MB?

HDFS gemmer terabyte og petabyte af data. Hvis HDFS-blokstørrelsen er 4 kb som Linux-filsystemet, vil vi have for mange datablokke i Hadoop HDFS, og derfor for meget metadata.

Så vedligeholdelse og styring af dette enorme antal blokke og metadata vil skabe enorme overhead og trafik, hvilket er noget, vi ikke ønsker.

Blokstørrelsen kan ikke være så stor, at systemet venter meget længe på, at en sidste enhed af databehandling afslutter sit arbejde.

Fordele ved HDFS

Efter at have lært, hvad der er HDFS Data Block, lad os nu diskutere fordelene ved Hadoop HDFS.

1. Mulighed for at gemme meget store filer

Hadoop HDFS gemmer meget store filer, som er endnu større end størrelsen på en enkelt disk, da Hadoop framework deler filer i blokke og distribuerer på tværs af forskellige noder.

2. Fejltolerance og høj tilgængelighed af HDFS

Hadoop framework kan nemt replikere blokke mellem datanoderne. Giv derfor fejltolerance og høj tilgængelighed HDFS.

3. Enkel lagringsstyring

Da HDFS har fast blokstørrelse (128MB), så er det meget nemt at beregne antallet af blokke, der kan gemmes på disken.

4. Simpel lagringsmekanisme til datanoder

Blokering i HDFS forenkler opbevaringen afDatanoderne . Namenode vedligeholder metadata for alle blokkene. HDFS Datanode behøver ikke bekymre sig om blokmetadata som filtilladelser osv.

Konklusion

Derfor er HDFS-datablok den mindste dataenhed i et filsystem. Standardstørrelsen på HDFS-blokken er 128 MB, som du kan konfigurere efter behov. HDFS-blokke er nemme at replikere mellem datanoderne. Sørg derfor for fejltolerance og høj tilgængelighed af HDFS.

For enhver forespørgsel eller forslag relateret til Hadoop HDFS-datablokke, lad os det vide ved at efterlade en kommentar i et afsnit nedenfor.