Digital transformation er et varmt emne for alle markeder og industrier, da det leverer værdi med eksplosive vækstrater. Tænk på, at Manufacturing's Industry Internet of Things (IIOT) blev vurderet til $161 mia. med en imponerende vækstrate på 25 %, vil markedet for tilsluttede biler blive vurderet til $225 mia. i 2027 med en vækstrate på 17 %, eller det i de første tre måneder af I 2020 realiserede detailhandlere ti års digital salgspenetration på kun tre måneder. Det meste af det, der skrives, har dog at gøre med de muliggørende teknologiplatforme (cloud- eller edge- eller punktløsninger som datavarehuse) eller use cases, der driver disse fordele (forudsigende analyser anvendt til forebyggende vedligeholdelse, finansinstitutioners opdagelse af svindel eller forudsigelig helbredsovervågning som eksempler) ikke de underliggende data. Det manglende kapitel handler ikke om punktløsninger eller brugscases modenhedsrejse. Det manglende kapitel handler om dataene – det handler altid om dataene – og vigtigst af alt, rejsedataene væver sig fra kant til kunstig intelligensindsigt.

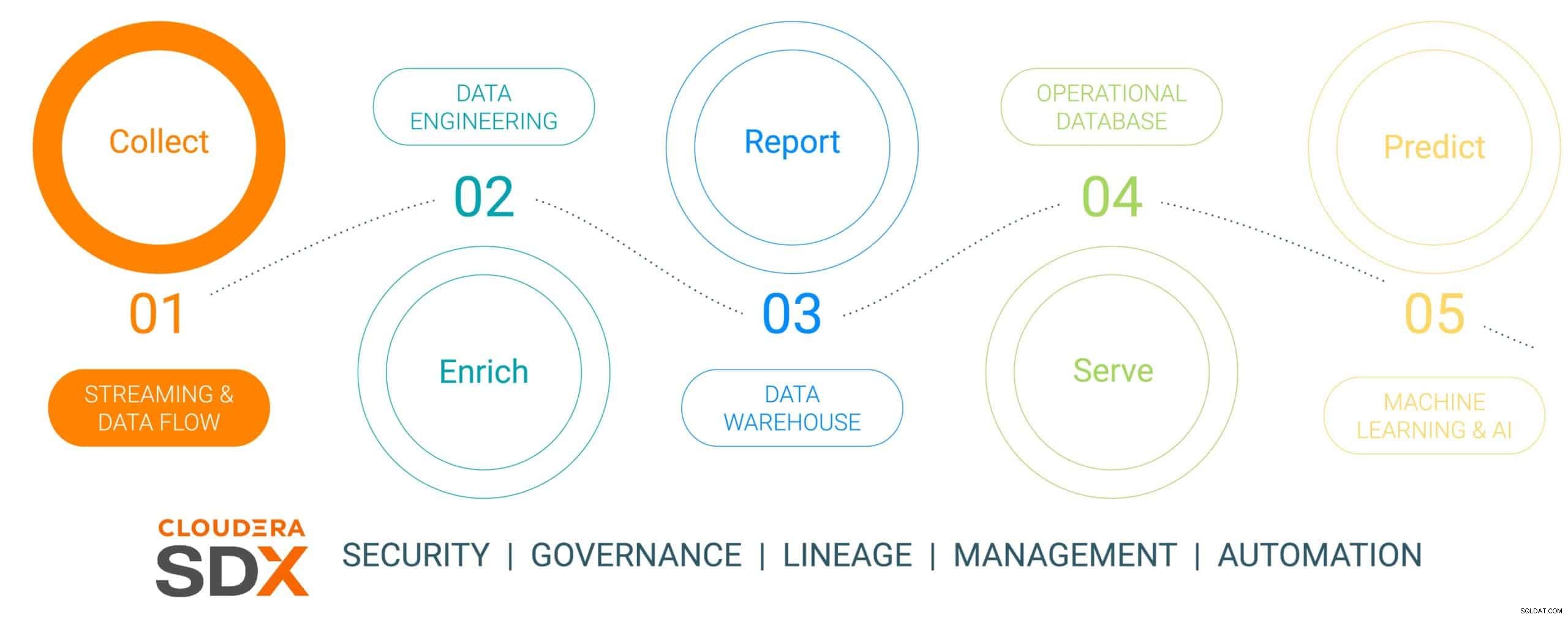

Dette er den første i en seksdelt blogserie, der skitserer datarejsen fra kant til AI og den forretningsværdi, data producerer undervejs. Datarejsen er ikke lineær, men den er en uendelig løkke-datalivscyklus – der initieres ved kanten, væver sig gennem en dataplatform og resulterer i indsigt, der er nødvendig for virksomheden, anvendt på reelle forretningskritiske problemer, der resulterer i nye dataledede initiativer. Vi har forenklet denne rejse til fem diskrete trin med et fælles sjette trin, der taler om datasikkerhed og styring. De seks trin er:

- Dataindsamling – dataindtagelse og overvågning på kanten (uanset om kanten er industrielle sensorer eller mennesker i en mursten og mørtel detailbutik)

- Databerigelse – datapipelinebehandling, -aggregering og -styring for at klargøre dataene til yderligere forfining

- Rapportering – at levere indsigt i virksomheden (salgsanalyse og prognoser, markedsundersøgelser, budgettering som eksempler)

- Visning – kontrol og drift af væsentlige forretningsaktiviteter (ATM-transaktioner, detailudbetaling eller produktionsovervågning)

- Prediktiv analyse – prædiktiv analyse baseret på AI og maskinlæring (svigdetektion, forudsigelig vedligeholdelse, efterspørgselsbaseret lageroptimering som eksempler)

- Sikkerhed og styring – et integreret sæt sikkerheds-, styrings- og styringsteknologier på tværs af hele datalivscyklussen

Fig. 1:Enterprise Data Lifecycle

For at illustrere datarejsen har vi valgt et meget relevant og bæredygtigt tænkende fremstillingsemne – fremstilling af en elbil, valgt fordi fremstillingsoperationerne normalt er revolutionerende af natur (høj digital modenhed ved at implementere de mest opdaterede dataværktøjer) , sammenlignet med "old-school evolutionær" (af lavere modenhed), og at de fleste af disse biler er bygget som Connected Mobility platforme, hvilket gør bilen til mere end blot transport, men en platform for datadrevet viden og indsigt. Denne historie viser, hvordan data indsamles, beriges, opbevares, serveres og derefter bruges til at forudsige begivenheder i bilens fremstillingsproces ved hjælp af Cloudera Data Platform.

Denne historie vil indeholde et falskt, forbundet køretøjsfabrikant af elektriske køretøjer kaldet (med et meget originalt navn på) The Electric Car Company (ECC). ECC driver flere produktionsfabrikker placeret over hele kloden, er vertikalt integreret i at bygge sine egne biler såvel som mange af de kritiske komponenter, herunder elektriske motorer, batterier og hjælpedele. Hver fabrik har til opgave at fremstille forskellige komponenter, og den endelige samling finder sted på nogle få udvalgte, strategisk placerede fabrikker.

Dataindsamlingsudfordring

Håndtering af indsamlingen af alle data fra alle fabrikker i fremstillingsprocessen er en betydelig opgave, der giver nogle få udfordringer:

- Vanskeligheder ved at vurdere mængden og variationen af IoT-data: Mange fabrikker bruger både moderne og ældre produktionsaktiver og enheder fra flere leverandører med forskellige protokoller og dataformater. Selvom controllerne og enhederne kan være forbundet til et OT-system, er de normalt ikke forbundet på en måde, så de også nemt kan dele dataene med it-systemer. For at muliggøre forbundet produktion og nye IoT-brugssager har ECC brug for en løsning, der kan håndtere alle typer forskellige datastrukturer og skemaer fra kanten, normalisere dataene og derefter dele dem med enhver type dataforbruger, inklusive Big Data-applikationer.

- Styring af kompleksiteten af realtidsdata: For at ECC kan drive forudsigelige analyseanvendelser, skal en dataadministrationsplatform aktivere realtidsanalyse på streaming af data. Platformen skal også effektivt indtage, gemme og behandle streamingdataene i realtid eller næsten realtid for øjeblikkeligt at levere indsigt og handling.

- Frigivelse af data fra uafhængige siloer: Specialiserede processer (innovationsplatforme, QMS, MES osv.) inden for produktionsværdikæden belønner forskellige datakilder og datastyringsplatforme, der skræddersyes til unikke siled-løsninger. Disse nicheløsninger begrænser virksomhedens værdi, idet de kun tager hensyn til en brøkdel af den indsigt, som data på tværs af virksomheder kan tilbyde, samtidig med at virksomheden opdeles og samarbejdsmulighederne begrænses. Den rigtige platform skal have evnen til at indtage, lagre, administrere, analysere og behandle streaming data fra alle punkter i værdikæden, kombinere det med datahistorikere, ERP, MES og QMS kilder og udnytte det til handlingsvenlig indsigt. Disse indsigter vil levere dashboards, rapporter og forudsigelige analyser, der driver høj værdi produktionsbrug.

- Balancering af kanten: At forstå den rette balance mellem databehandling ved kanten og i skyen er en udfordring, og derfor skal hele datalivscyklussen overvejes. Der er en bekymrende tendens i branchen, da virksomheder vælger at fokusere på det ene eller det andet uden at indse, at de kan og bør gøre begge dele. Cloud computing har sine fordele til langsigtet analyse og storstilet udrulning, men den er begrænset af båndbredde og indsamler ofte enorme mængder data, mens den kun bruger en lille del. Værdien af kanten ligger i at handle på den kant, hvor den har størst effekt med nul latens, før den sender de mest værdifulde data til skyen for yderligere højtydende behandling.

Dataindsamling ved hjælp af Cloudera Data Platform

TRIN 1:Indsamling af rådata

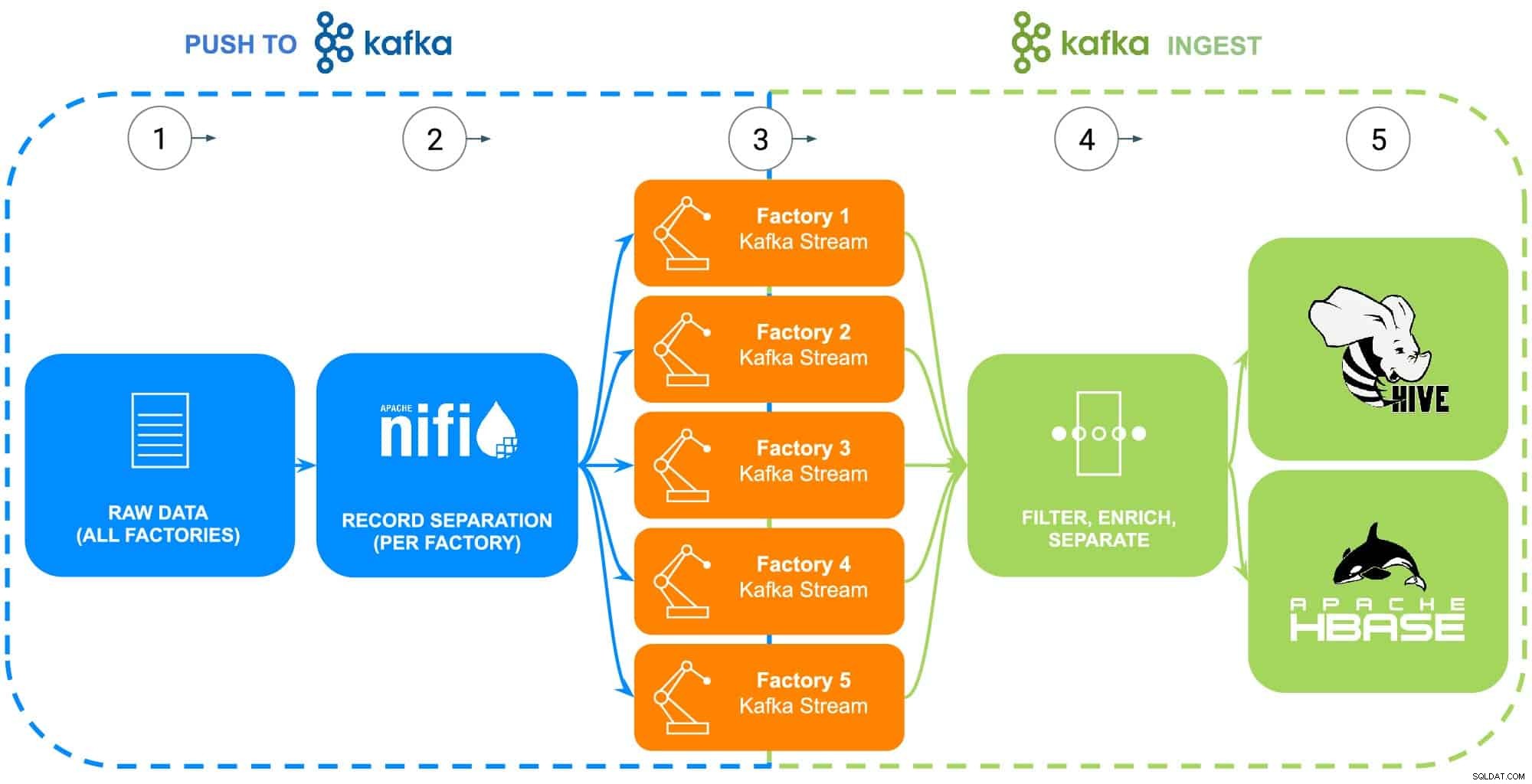

Data fra ECC's fremstilling omfatter en lang række kilder – industrirobotter, body-in-white fosfatbelægningsprocestanke (temperatur, koncentration eller genopfyldning), forsyningskædetelematik eller masterdelinformation osv. For dette specifikke eksempel er rådelen. stamdata for hver af ECC's fem fabrikker er blevet indsamlet som forberedelse til at blive ført til Apache NiFi (se fig. 2).

TRIN 2:Konfigurer datakilder for hver fabrik

Dataindsamling vil blive illustreret ved hjælp af Clouderas Data Flow-oplevelse (drevet af Apache NiFi) til at hente disse rådata og opdele dem i individuelle fabriksstrømme (administreret af Apache Kafka) for mere præcist at ligne et scenarie i den virkelige verden (se Fig. 2). For at holde eksemplet simpelt blev følgende dataattributtags valgt for hver del genereret af fabrikkerne:

- Fabriks-id

- Maskin-id

- Fremstillet tidsstempel

- Artikelnummer

- Serienummer

Fig. 2:Dataindsamlingsflowdiagram.

TRIN 3:Overvåg datagennemstrømning fra hver fabrik

Med alle data, der nu flyder ind i individuelle Kafka-strømme, overvåger en dataarkitekt datagennemstrømning fra hver fabrik samt justerer de nødvendige beregnings- og lagerressourcer for at sikre, at hver fabrik har den nødvendige gennemstrømning til at sende data ind i platformen.

TRIN 4:Optag data fra Apache Kafka-streams

Kafka fanger alle fabriksdatastrømme og samler dem i processorer, der både filtrerer og beriger til brug i styring og drift af væsentlige forretningsaktiviteter drevet af en operationel database eller leverer indsigt i virksomheden gennem et virksomhedsdatavarehus eller bruges i avanceret analyse.

ECC har for nylig startet produktionen af en opgraderet version af deres elmotor, der kun produceres i fabrik 5, disse data vil blive brugt som illustration af de næste trin i datalivscyklussen

TRIN 5:Push data til lagerløsninger

Da ECC-produktions- og kvalitetsingeniørerne vil nøje overvåge implementeringen og brugen af denne motor i marken, filtreres de specifikke produktionssporbarhedsdata ind i en separat rute og gemmes i sin egen tabel i Apache Hive. Dette vil gøre det muligt for ingeniørerne at køre ad-hoc-forespørgsler i Cloudera Data Warehouse mod dataene senere, såvel som at forbinde dem med andre relevante data i virksomhedens datavarehus, såsom reparationsordrer eller kundefeedback for at producere forhåndsbrugssager som garanti, forudsigende vedligeholdelsesrutiner eller input til produktudvikling.

Alternativt, hvis det ønskes at kontrollere og køre væsentlige forretningsaktiviteter, vil hele datasættet med tilføjelse af et behandlet tidsstempel blive sendt ind i den Apache HBase-drevne Cloudera Operational Database. Disse data vil tjene som grundlaget for, at ECC kan køre deres inventarplatform, hvilket vil kræve brug af konstante læse/skrive-operationer, da inventar både kan tilføjes og fjernes tusindvis af gange om dagen. Da HBase er designet til at håndtere disse former for datatransaktioner i stor skala, fungerer det som den bedste løsning på denne unikke udfordring.

Konklusion

Denne enkle illustration viser vigtigheden af at få dataindtagelse rigtigt, da den er grundlaget for indsigt leveret fra både operationelle databaser, virksomhedsdatavarehuse eller avanceret analytisk maskinlæringsprædiktiv analyse. Værdien i at "få det rigtigt" inkluderer brug af data fra enhver virksomhedskilde og dermed nedbrydning af datasiloer, brug af alle data, uanset om det er streaming eller batch-orienteret, og evnen til at sende disse data til det rigtige sted, hvilket giver den ønskede downstream-indsigt.

Ved at bruge CDP, kan ECC-dataingeniører og andre branchebrugere begynde at bruge indsamlede data til forskellige opgaver lige fra lagerstyring til reservedelsprognose til maskinlæring. Da Cloudera Data Flow fremmer realtidsdataindtagelse fra enhver virksomhedskilde, kan den udvides og vedligeholdes uden omfattende viden om forskellige programmeringssprog og proprietære dataindsamlingsmetoder. Hvis der opstår unikke problemer, kan ingeniører også skabe deres egne processer til ægte, finmasket kontrol.

Se efter den næste blog, der vil dykke ned i databerigelse, og hvordan den understøtter datalivscyklushistorien. Derudover vil denne historie blive udvidet med datadrevne demoer, der viser datarejsen gennem hvert trin i datalivscyklussen.

Flere ressourcer til dataindsamling

For at se alt dette i aktion, klik venligst på de relaterede links nedenfor for at lære mere Dataindsamling:

- Video – Hvis du gerne vil se og høre, hvordan dette blev bygget, kan du se videoen på linket.

- Tutorials – Hvis du gerne vil gøre dette i dit eget tempo, kan du se en detaljeret gennemgang med skærmbilleder og linje for linje instruktioner om, hvordan du opsætter og udfører dette.

- Meetup – Hvis du vil tale direkte med eksperter fra Cloudera, bedes du deltage i et virtuelt møde for at se en livestreampræsentation. Der vil være tid til direkte spørgsmål og svar til sidst.

- Brugere – Klik på linket for at se mere teknisk indhold specifikt for brugere.