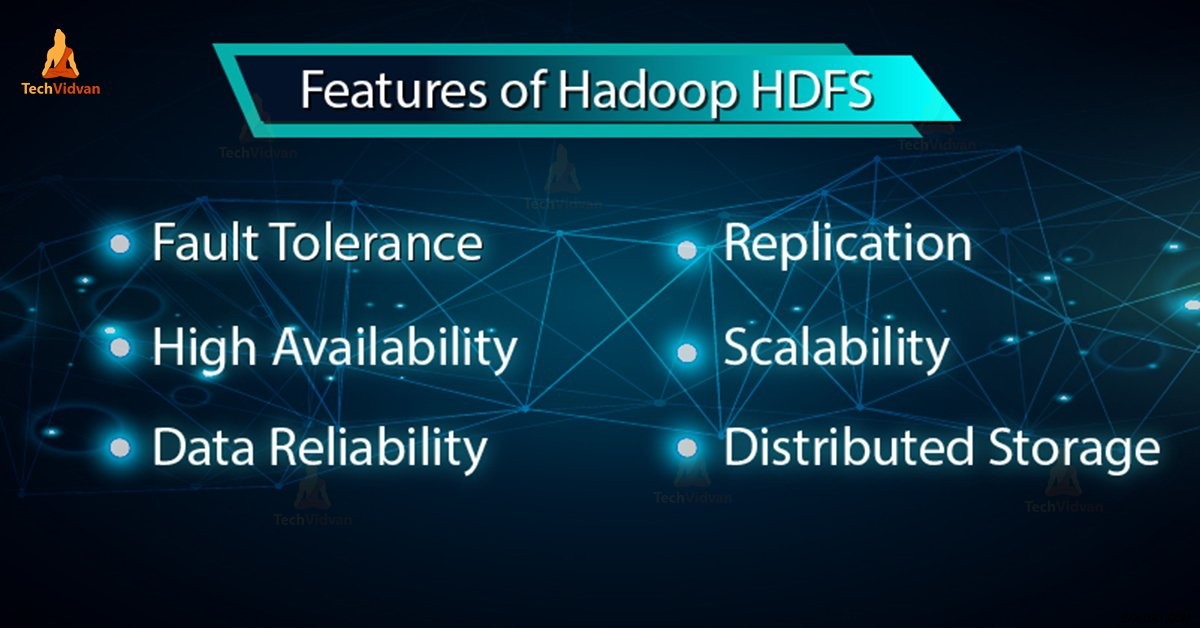

I vores tidligere blog har vi lært Hadoop HDFS i detaljer, nu i denne blog, vil vi dække funktionerne i HDFS. Hadoop HDFS har funktioner som fejltolerance, replikering, pålidelighed, høj tilgængelighed, distribueret lagring, skalerbarhed osv.

Alle disse funktioner i HDFS i Hadoop vil blive diskuteret i denne Hadoop HDFS tutorial.

Introduktion til Hadoop HDFS

Hadoop distribueret filsystem (HDFS) er Hadoops primære lagersystem. Det gemmer meget store filer, der kører på en klynge af råvarehardware. HDFS er baseret på GFS (Google FileSystem). Den gemmer data pålideligt, selv i tilfælde af hardwarefejl.

HDFS giver også high-throughput adgang til applikationen ved at få adgang parallelt. Ifølge en forudsigelse ved udgangen af 2017 vil 75 % af de tilgængelige data på planeten være i HDFS.

6 vigtige funktioner i HDFS

Efter at have studeret Hadoop HDFS-introduktionen, lad os nu diskutere de vigtigste funktioner ved HDFS.

1. Fejltolerance

Fejltolerancen i Hadoop HDFS er et systems arbejdsstyrke under ugunstige forhold. Den er meget fejltolerant. Hadoop framework opdeler data i blokke. Derefter oprettes flere kopier af blokke på forskellige maskiner i klyngen.

Så når en hvilken som helst maskine i klyngen går ned, kan en klient nemt få adgang til deres data fra den anden maskine, som indeholder den samme kopi af datablokke.

2. Høj tilgængelighed

Hadoop HDFS er et meget tilgængeligt filsystem. I HDFS bliver data replikeret blandt noderne i Hadoop-klyngen ved at oprette en replika af blokkene på de andre slaver, der er til stede i HDFS-klyngen. Så hver gang en bruger ønsker at få adgang til disse data, kan de få adgang til deres data fra slaverne, som indeholder dets blokke.

På tidspunktet for ugunstige situationer som en fejl i en node, kan en bruger nemt få adgang til deres data fra de andre noder. Fordi duplikerede kopier af blokke er til stede på de andre noder i HDFS-klyngen.

3. Høj pålidelighed

HDFS giver pålidelig datalagring. Den kan gemme data i intervallet 100'er af petabytes. HDFS gemmer data pålideligt på en klynge. Det opdeler dataene i blokke. Hadoop framework gemmer disse blokke på noder til stede i HDFS cluster.

HDFS gemmer data pålideligt ved at skabe en replika af hver eneste blok, der er til stede i klyngen. Giver derfor fejltolerancefacilitet. Hvis noden i klyngen, der indeholder data, går ned, kan en bruger nemt få adgang til disse data fra de andre noder.

HDFS opretter som standard 3 replikaer af hver blok, der indeholder data til stede i noderne. Så data er hurtigt tilgængelige for brugerne. Derfor står brugeren ikke over for problemet med tab af data. HDFS er således yderst pålidelig.

4. Replikering

Datareplikering er unikke funktioner i HDFS. Replikering løser problemet med tab af data i en ugunstig tilstand som hardwarefejl, nedbrud af noder osv. HDFS opretholder replikeringsprocessen med regelmæssige tidsintervaller.

HDFS bliver også ved med at skabe replikaer af brugerdata på forskellige maskiner, der er til stede i klyngen. Så når en node går ned, kan brugeren få adgang til dataene fra andre maskiner. Der er således ingen mulighed for at miste brugerdata.

5. Skalerbarhed

Hadoop HDFS gemmer data på flere noder i klyngen. Så hver gang kravene stiger, kan du skalere klyngen. To skalerbarhedsmekanismer er tilgængelige i HDFS:Lodret og Horisontal skalerbarhed.

6. Distribueret lager

Alle funktionerne i HDFS opnås via distribueret lagring og replikering. HDFS gemmer data på en distribueret måde på tværs af noderne. I Hadoop er data opdelt i blokke og lagret på noderne i HDFS-klyngen.

Derefter opretter HDFS replikaen af hver eneste blok og gemmer på andre noder. Når en enkelt maskine i klyngen går ned, kan vi nemt få adgang til vores data fra de andre noder, som indeholder dens replika.

Konklusion

Afslutningsvis kan vi sige, at HDFS er meget fejltolerant. Det gemmer pålideligt enorme mængder data på trods af hardwarefejl. Det giver også høj skalerbarhed og høj tilgængelighed. Derfor styrker HDFS Hadoop-funktionalitet. Hvis du finder andre funktioner i HDFS, så del venligst med os i kommentarfeltet nedenfor.