Relationelle databaser var i lang tid nok til at håndtere små eller mellemstore datasæt. Men den kolossale hastighed, hvormed data vokser, gør den traditionelle tilgang til datalagring og -hentning umulig. Dette problem bliver løst af nyere teknologier, som kan håndtere Big Data. Hadoop, Hive og Hbase er de populære platforme til at betjene denne slags store datasæt. NoSQL eller ikke kun SQL-databaser såsom MongoDB® giver en mekanisme til at gemme og hente data i en taberkonsistensmodel med fordele som:

- Horisontal skalering

- Højere tilgængelighed

- Hurtigere adgang

MongoDB® ingeniørteamet har for nylig opdateret MongoDB® Connector til Hadoop for at få bedre integration. Dette gør det nemmere for Hadoop-brugere at:

- Integrer realtidsdata fra MongoDB® med Hadoop til dyb, offline analyse.

- Connektoren afslører den analytiske kraft i Hadoops MapReduce for live applikationsdata fra MongoDB®, hvilket skaber værdi fra big data hurtigere og mere effektivt.

- Forbinderen præsenterer MongoDB som et Hadoop-kompatibelt filsystem, der gør det muligt for et MapReduce-job at læse fra MongoDB® direkte uden først at kopiere det til HDFS (Hadoop-filsystem), og derved fjerne behovet for at flytte terabyte data på tværs af netværket.

- MapReduce-job kan sende forespørgsler som filtre, så man undgår behovet for at scanne hele samlinger, og kan også drage fordel af MongoDB®s rige indekseringsmuligheder, herunder geo-spatial, tekst- søge-, array-, sammensatte og sparsomme indekser.

- Læsning fra MongoDB®, kan resultaterne af Hadoop-job også skrives tilbage til MongoDB® for at understøtte driftsprocesser i realtid og ad-hoc-forespørgsler.

Hadoop- og MongoDB®-brugssager:

Lad os se på en beskrivelse på højt niveau af, hvordan MongoDB® og Hadoop kan passe sammen i en typisk Big Data-stack. Primært har vi:

- MongoDB® bruges som "Operationel" realtidsdatalager

- Hadoop til offline batchdatabehandling og -analyse

Læs videre for at vide, hvorfor MongoDB er databasen til Big Data-behandling oghvordan MongoDB® blev brugt af virksomheder og organisationer som Aadhar, Shutterfly, Metlife og eBay.

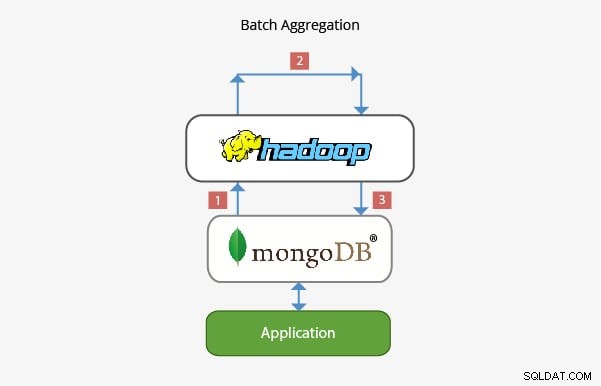

Anvendelse af MongoDB® med Hadoop i Batch Aggregation:

I de fleste scenarier er den indbyggede aggregeringsfunktionalitet fra MongoDB® tilstrækkelig til at analysere data. I visse tilfælde kan det dog være nødvendigt med væsentlig mere kompleks dataaggregering. Det er her, Hadoop kan levere en kraftfuld ramme for komplekse analyser.

I dette scenarie:

- Data hentes fra MongoDB® og behandles i Hadoop via et eller flere MapReduce-job. Data kan også hentes fra andre steder inden for disse MapReduce-opgaver for at udvikle en multidatakildeløsning.

- Output fra disse MapReduce-job kan derefter skrives tilbage til MongoDB® til forespørgsel på et senere tidspunkt og til enhver analyse på ad hoc-basis.

- Applikationer bygget oven på MongoDB® kan derfor bruge informationen fra batchanalyse til at præsentere for slutklienten eller til at aktivere andre downstream-funktioner.

Applikation i Data Warehousing:

I en typisk produktionsopsætning kan applikationens data ligge i flere datalagre, hver med deres eget forespørgselssprog og funktionalitet. For at reducere kompleksiteten i disse scenarier kan Hadoop bruges som et datavarehus og fungere som et centraliseret lager for data fra de forskellige kilder.

I denne slags scenarier:

- Periodic MapReduce-job indlæser data fra MongoDB® til Hadoop.

- Når dataene fra MongoDB® og andre kilder er tilgængelige i Hadoop, kan der forespørges mod det større datasæt.

- Dataanalytikere har nu mulighed for at bruge enten MapReduce eller Pig til at oprette jobs, der forespørger de større datasæt, der inkorporerer data fra MongoDB®.

Teamet, der arbejder bag MongoDB® har sikret, at det med sin rige integration med Big Data-teknologier som Hadoop er i stand til at integrere godt i Big Data-stakken og hjælpe med at løse nogle komplekse arkitektoniske problemer når det kommer til datalagring, genfinding, behandling, aggregering og lager. Hold dig opdateret på vores kommende indlæg om karrieremuligheder for dem, der starter Hadoop med MongoDB®. Hvis du allerede arbejder med Hadoop eller bare henter MongoDB®, så tjek de kurser, vi tilbyder til MongoDB® her

Udforsk mere om Hadoop-koncepter. Tjek dette Online Big Data kursus , som blev skabt af Top Industrial Working Experts.