Bemærk:Denne artikel blev oprindeligt udarbejdet i 2015, men blev opdateret i 2019 for at afspejle ny integration mellem IRI Voracity og Knime (for Konstanz Information Miner), nu den mest kraftfulde open source-datamineplatform til rådighed.

Data mining er videnskaben om at udlede viden fra data, typisk store datasæt, hvor meningsfuld information, tendenser og anden nyttig indsigt skal opdages. Data mining bruger maskinlæring og statistiske metoder til at udtrække nyttige "klumper" af information fra, hvad der ellers ville være et meget skræmmende datasæt.

Data mining spænder over flere computer- og matematiske discipliner. Det er ikke så meget en enhedsproces, som det er en paraplybetegnelse for et sæt handlinger. Fire brede opgaver, der udføres under minedrift, omfatter: udforskende dataanalyse (EDA), deskriptiv modellering, forudsigelig modellering og mønsteropdagelse.

EDA bruger konventionelle statistiske visualiseringsmetoder eller ukonventionelle grafiske metoder for at se, om der kan findes noget interessant i dataene.

Ved deskriptiv modellering overføres dataene til en rutine og giver verber (datageneratorer) eller adjektiver (databeskrivelser), der ligger bag dannelsen af dataene. Dette inkluderer metoder, der forbinder dataene med en sandsynlighedsfordeling, klynge- og afhængighedsmodellering.

Forudsigende modellering bruger regression og klassificeringsmetoder til at opsætte en standard til at forudsige fremtidige ukendte datapunkter. Regression er en rent matematisk analyse, der tilpasser en ligning til et datasæt for at forudsige den næste værdi. Forudsigende modellering kan også stole på mønsterregler og forhold (eller endda specifikt identificerede årsag og virkning) tendenser, der blev opdaget ved hjælp af LAD-metoden (Logical Analysis of Data).

Mønsteropdagelse via LAD klassificerer nye observationer i henhold til tidligere klassifikationer af observationerne og bruger optimering, kombinatoriske og boolske funktioner til at forbedre analysens nøjagtighed.

For det meste kan disse metoder kun angive, hvilke dataindtastninger der er relateret, men ikke årsagerne til, eller hvordan de er relateret. Det er muligt at forklare, hvad der karakteriserer en klasse/klynge fra en anden ved at finde disse regler eller mønstre, og emnerne er opstillet på forskellige måder afhængig af selve dataene.

Ansøgninger til datamining kan variere fra virksomhedsmarkedsføring til medicin, fra opdagelse af svindel i bank- og forsikringsvirksomhed til astronomi, fra personalestyring til katalogmarkedsføringsindustrien og så videre. Den medicinske profession har fundet det nyttigt at skelne mellem egenskaber hos mennesker med forskellige sygdomsprogressionshastigheder. Detailbutikker bruger nu data mining til bedre at forstå forbrugernes forbrugsvaner, idet de noterer sig, hvilke varer der købes sammen og deres relation, samt den bedste måde at annoncere over for deres kunder. Og en stor del af virksomhedsverdenen er nu afhængig af datamining til at beregne, udføre og retfærdiggøre store forretningsbeslutninger.

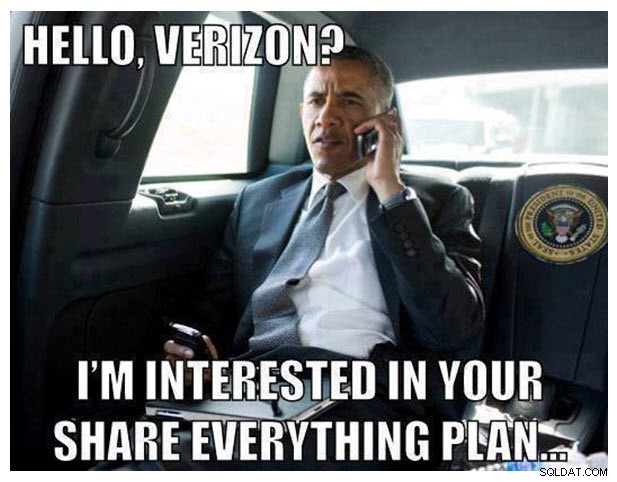

Men som alle nu ved fra den seneste intense mediedækning af NSA-Verizon telefonregistreringsskandalen, kan datamining også være ekstremt kontroversielt. Bare hvis du har boet under en sten, er her en kort synopsis:

Den 5. juni 2013 offentliggjorde det britiske dagblad kaldet The Guardian en eksklusiv rapport om, at millioner af kunderegistreringer fra Verizon, en af de største telekommunikationsudbydere i USA, blev indsamlet af det amerikanske nationale sikkerhedsagentur som svar på en klassificeret ordre fra U.S. Foreign Intelligence Surveillance Court. Verizons Business Network Services blev tvunget til at udlevere alle telefoni-metadata oprettet af mobiludbyderen i USA og i udlandet. Som et resultat udbrød bi-partisk og universel kritik af Obama-administrationen derefter fra borgerrettighedsfortalergrupper og nyhedsmedier, der hævdede præsidentens misbrug af den udøvende magt. Ingen løsning på denne hændelse er i sigte, da denne artikel blev skrevet. Men det vil utvivlsomt forblive som et godt eksempel på, hvordan datamining nogle gange kan ses i et negativt lys, især med hensyn til privatlivsproblemer og offentligheden generelt.

Når man beskæftiger sig med store mængder statiske eller dynamiske data, vil der helt sikkert være beregningsmæssige og I/O-relaterede præstationsproblemer. Med databaser, der indeholder terabyte og exabyte af data, kan det tage meget tid at kæmme dataene igennem, og minealgoritmerne skal køre meget effektivt. Nogle andre vanskeligheder omfatter overtilpasning og støjende data.

Overfitting betyder normalt, at der ikke er nok gode data tilgængelige. Datamodellen (i dette tilfælde den globale beskrivelse af dataene) bliver for kompleks, fordi den har for mange parametre i forhold til antallet af observationer. Dette overdriver mindre udsving i dataene og kompromitterer dermed modellens pålidelighed som grundlag for forudsigelser.

Støjende data henviser på den anden side til for meget af den forkerte slags data. Meningsløse, fejlagtige, ustrukturerede (ulæselige) eller på anden måde korrupte data øger lagerkravene og/eller kræver, at statistisk analyse luges ud, før det kan hæmme data mining-nøjagtigheden. Gode datamining-algoritmer tager højde for støjende data.

Data mining er et enkelt trin i en større proces kendt som videnopdagelse i databaser (KDD). KDD begynder først med dataforberedelse: udvælgelse, forbehandling og transformation af dataene, hvor du bestemmer, hvad du vil studere og sætter det op på en måde, der kan udvindes. Det vil sige at repræsentere data som en m-n matrix og med en numerisk repræsentation af elementet i hver datavektor. Dernæst er du min. Og endelig kommer du til at bruge den gamle noggin til at fortolke og analysere den information. Så, hvis de skjulte mønstre og tendenser stadig ikke er klare nok, skal du grave lidt dybere.

IRIs rolle i datamining og KDD-proces er at klargøre og omstrukturere big data til analyse gennem flere højtydende datatransformationsfunktioner. Specifikt kan IRI CoSort-datamanipulationspakken hurtigt filtrere, manipulere og omformatere data, så de kan behandles af data mining-algoritmer som disse data mining-softwarepakker. CoSort er også standarddatabehandlingsmotoren i IRI Voracity-dataadministrationsplatformen, designet til en bred vifte af dataprofilering, forberedelse og skænderier.

For dem, der arbejder med CoSort i IRI Workbench GUI, er BIRT et gratis Eclipse-plug-in med grafisk rapportering og business intelligence-funktioner, som inkluderer nogle analyse- og minefunktioner. Både CoSort og BIRT Analytics bruger Eclipse IDE. Med Open Data Access (ODA) datadriverunderstøttelse, der går ind i CoSort, er dataflowintegrationen mellem de to plug-ins også problemfri og giver mulighed for hurtigere what-if-analyser.

For dem, der arbejder med Voracity i 2019 og derefter, foreslår vi, at du installerer kerneudbyderen til den gratis Knime Analytics Platform i IRI Workbench. I den samme Eclipse-glasrude kan Voracity-kildenoden (udbyder) for Knime aflevere den Voracity-forberedte rådata i hukommelsen til Knime-knudepunkter til applikationer, der kræver statistisk og forudsigelig analyse, datamining og maskin/dyb læring, neurale netværk og kunstig intelligens.

Bidragydere til denne artikel omfatter Roby Poteau og David Friedland